什么是模型上下文协议(MCP)?

模型上下文协议(Model Context Protocol,简称MCP)是由Anthropic推出的开放标准,旨在为大型语言模型(LLMs)提供一种标准化的方式,以连接和访问外部的数据源和工具。

MCP的设计初衷是解决LLMs在实际应用中面临的两个主要挑战:

- 知识更新滞后:LLMs的知识基于其训练数据,难以及时获取最新信息。

- 缺乏专业领域知识:LLMs通常缺乏对特定业务场景的深入理解。

通过MCP,开发者可以为LLMs提供实时的上下文信息,使其能够更准确地理解和响应用户的请求。

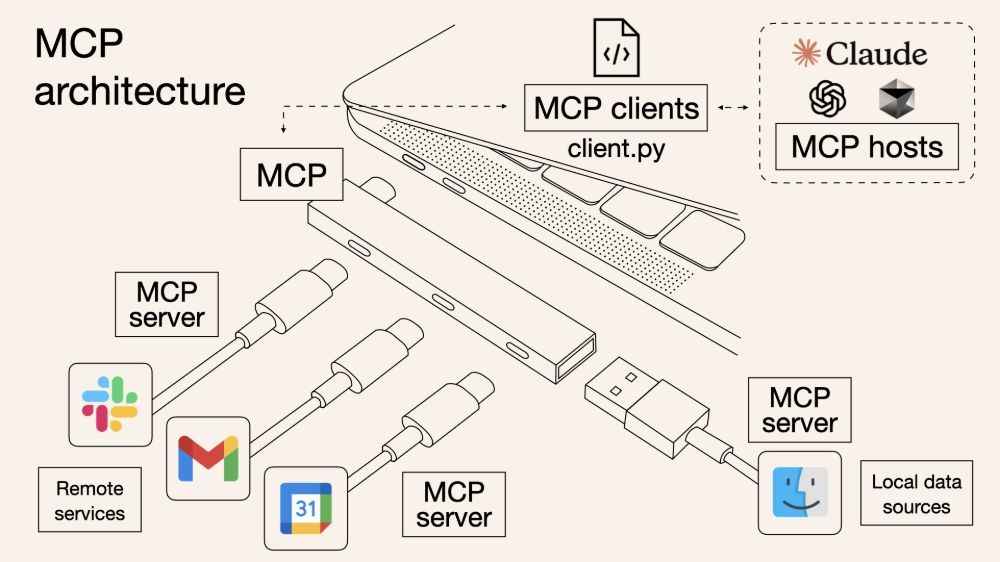

MCP的工作原理

MCP采用客户端-服务器架构,主要包括以下组件:

- MCP客户端:位于LLM或其服务基础设施端,负责构建请求并发送给MCP服务器。

- MCP服务器:与外部系统交互,获取数据并按照MCP协议规范格式化后返回给客户端。

通信采用JSON-RPC 2.0协议,支持状态连接和能力协商,确保客户端和服务器之间的高效、安全通信。

MCP的核心功能

MCP服务器可以向客户端提供以下三种主要功能:

- 工具(Tools):可被AI模型调用的函数,如获取天气预报、查询数据库等。

- 资源(Resources):可被客户端读取的类文件数据,如文档、配置文件等。

- 提示(Prompts):帮助用户完成特定任务的预设模板,优化AI模型的输出。

此外,MCP还支持配置、进度跟踪、取消、错误报告和日志记录等附加功能,增强协议的实用性。

MCP的应用场景

MCP在多个领域具有广泛的应用前景,包括:

- 增强型AI助手:通过连接外部数据源,提高AI助手的响应准确性和实用性。

- 知识管理系统:实现LLMs对企业内部知识库的访问和利用。

- 客户服务聊天机器人:提供实时、个性化的客户支持。

- 内容创作工具:辅助用户进行高效的内容生成和编辑。

- 软件开发:集成代码库和开发工具,提升开发效率。

- 金融分析和医疗保健:实现对专业领域数据的访问和分析。

例如,开发者可以通过MCP将LLMs与GitHub连接,实现自动创建仓库、提交拉取请求等操作,显著提高开发效率。

为什么选择MCP?

MCP的优势主要体现在以下几个方面:

扩展性:允许LLMs访问外部工具和实时数据,增强其功能。

标准化:提供统一的交互协议,简化开发和集成过程。

安全性:通过用户授权机制和加密通信,确保数据安全。

灵活性:支持多种编程语言和平台,满足不同开发需求。

通过MCP,开发者可以构建各种工具来增强AI模型的能力,使其能够完成更多实际应用场景中的任务。

如何开始使用MCP?

要开始使用MCP,开发者可以:

- 阅读MCP的官方文档,了解协议规范和开发指南。

- 使用Anthropic提供的SDK,快速构建MCP客户端和服务器。

- 探索现有的MCP集成案例,借鉴最佳实践。

- 参与MCP的开源社区,贡献代码和反馈。

通过以上步骤,开发者可以迅速将MCP集成到自己的AI应用中,实现LLMs与外部数据源和工具的高效连接。

模型上下文协议(MCP)为大型语言模型提供了一个标准化的接口,使其能够连接和访问外部的数据源和工具,解决了LLMs在知识更新和专业领域知识方面的限制。通过MCP,开发者可以构建更强大、更灵活的AI应用,推动人工智能技术的广泛应用和发展。