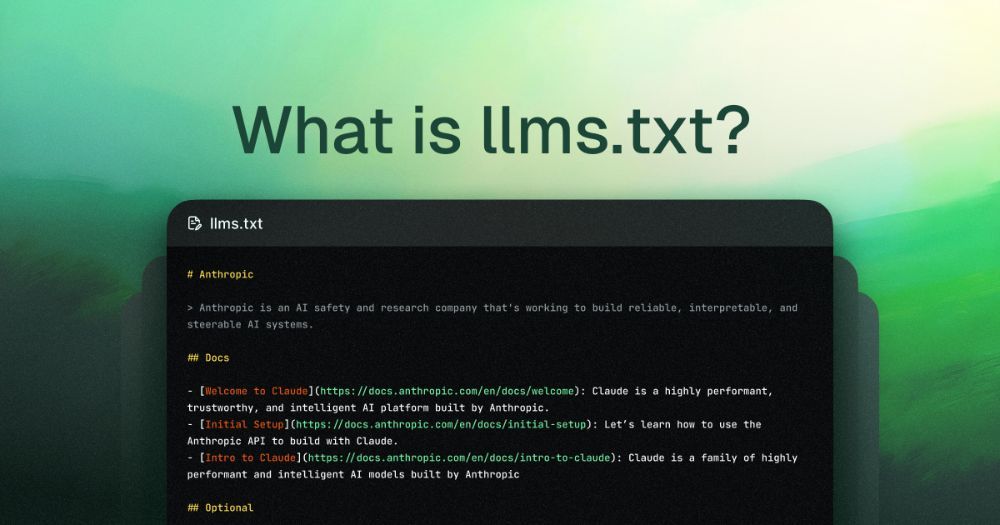

什么是 llms.txt?

llms.txt 是由 Answer.AI 联合创始人 Jeremy Howard 于 2024 年提出的一种新型文本文件标准,旨在帮助大型语言模型(LLMs)更高效地抓取和理解网站内容。它通过简洁的 Markdown 格式,向 AI 模型提供网站的关键结构和重要页面,从而提升内容在 AI 生成回答中的引用率。

与传统的 robots.txt 不同,llms.txt 并非用于限制搜索引擎的抓取行为,而是主动向 AI 模型展示网站的核心内容,属于“生成式引擎优化”(GEO)和“人工智能优化”(AIO)的实践工具之一。

llms.txt 的作用与优势

提升 AI 理解力:通过结构化的内容摘要,帮助 AI 模型快速识别网站的主要信息,避免误解或遗漏关键内容。

增强内容权威性:明确指出哪些页面是权威信息来源,增加在 AI 生成回答中的引用概率。

优化 AI 抓取效率:减少 AI 模型在解析复杂 HTML、JavaScript 等页面元素时的负担,提高抓取效率。

未来 SEO 的关键工具:随着 AI 搜索的兴起,llms.txt 成为网站在新型搜索环境中保持竞争力的重要手段。

llms.txt 的结构与编写规范

llms.txt 文件采用 Markdown 格式,建议包含以下元素:

- 一级标题(#):网站名称或品牌名。

- 引用块(>):简要描述网站的定位、目标受众和核心内容。

- 二级标题(##):主要内容分类,如产品、服务、博客等。

- 链接列表:每个分类下列出相关页面的链接。

llms.txt 示例:

# 示例科技公司

> 提供创新的 AI 解决方案,服务于全球客户。

## 产品与服务

- https://example.com/product1

- https://example.com/service1

## 博客文章

- https://example.com/blog/ai-trends

- https://example.com/blog/seo-strategies

## 联系我们

- https://example.com/contact

该文件应保存在网站根目录下,路径为 https://yourdomain.com/llms.txt,并确保对 AI 抓取工具(如 GPTBot、ClaudeBot 等)开放访问权限。

llms.txt 与 robots.txt 的区别

需要注意的是,llms.txt 文件应避免被传统搜索引擎索引,可在 robots.txt 中添加以下指令:

User-agent: *

Disallow: /llms.txt

这样可以防止搜索引擎将 llms.txt 文件作为网页内容收录,同时不影响 AI 模型的访问。

如何生成 llms.txt 文件?

可以手动编写 llms.txt 文件,或使用以下工具自动生成:

- WordLift llms.txt 生成器:自动抓取网站内容,生成标准化的 llms.txt 文件。

- GitHub 开源项目:如 llms.txt-and-llms-full.txt-Generator-For-SEO,提供基于 Streamlit 的生成工具。

使用这些工具可以节省时间,确保文件结构符合规范,提高 AI 模型的解析效率。

部署与维护建议

定期更新:随着网站内容的变化,及时更新 llms.txt 文件,保持信息的准确性。

简洁明了:避免过多冗余信息,突出重点内容,便于 AI 模型快速理解。

开放访问:确保 AI 抓取工具可以访问 llms.txt 文件,不被防火墙或权限设置阻挡。

结合其他优化手段:如结构化数据、语义标签等,共同提升网站在 AI 搜索中的表现。

随着 AI 技术的快速发展,传统的 SEO 策略已无法满足新的搜索需求。llms.txt 文件作为连接网站与 AI 模型的桥梁,正在成为提升网站可见性和权威性的关键工具。通过合理编写和部署 llms.txt 文件,你可以让 AI 更容易地收录和理解你的网站内容,在 AI 驱动的搜索时代中占据有利位置。